“O que impede o Dr. Mal de construir uma IA que vá destruir o mundo?”

ENTREVISTA Especialista em Inteligência Artificial confirma que não sabemos “como eles funcionam” nem “se eles sabem coisas”. O ChatGPT, diz, “não é uma IA para fins gerais, mas está a dar às pessoas uma amostra do que o será. A IA para fins gerais será completamente transformadora quando se concretizar”, avisa. E isso permitirá “melhores cuidados de saúde, melhor educação, novas formas espantosas de entretenimento e literatura e novas formas de arte”. Mas “há também muitas utilizações incorretas”. Aliás, sistemas atuais já têm muitos riscos, começando pelos “algoritmos das redes sociais”, que “têm mais controlo sobre o consumo cognitivo humano do que qualquer império ou ditador da história e, no entanto, não estão completamente regulamentados”. Com a IA, pior, a desinformação pode ser gerada de forma automatizada e adaptada a cada pessoa. Precisamos de regulação, diz. E questiona: “O que é que nós, a raça humana, queremos que seja o futuro?”

Nota do editor: esta é a primeira parte de um novo projeto da CNN que pretende analisar o potencial e os riscos da inteligência artificial (IA). “O nosso futuro com a IA: promessas e perigos” irá explorar a forma como a IA vai afetar as nossas vidas, a forma como trabalhamos e como nos compreendemos a nós próprios.

Atingimos um ponto de viragem na IA, diz especialista

Desde que o ChatGPT foi lançado, em novembro, a inteligência artificial tem estado no centro das atenções, provocando um enorme entusiasmo e debate sobre as suas possibilidades.

O ChatGPT, em conjunto com outras ferramentas de IA como o DALL-E, Midjourney, Stable Diffusion e Bard, acumulou milhões de utilizadores, que as utilizam para escrever e-mails, planear férias, fazerem-se passar por músicos, produzir anúncios e até desenhar edifícios.

Embora gigantes da tecnologia como Bill Gates tenham elogiado a possibilidade de a inteligência artificial poder reduzir a desigualdade global ou combater as alterações climáticas, a tecnologia também suscitou muito medo e ansiedade: irá a IA substituir milhões de empregos? A desinformação tornar-se-á ainda mais generalizada? A IA de objetivos gerais - IA tão capaz como os humanos - acabará por dominar o mundo?

Falámos com Stuart Russell, professor de ciências informáticas na Universidade da Califórnia, em Berkeley, co-autor do livro "Artificial Intelligence: A Modern Approach", sobre as promessas e os riscos da IA, e se é possível garantir que ela permanece segura e sob o nosso controlo.

Segundo Russell, os modelos linguísticos de grande dimensão como o ChatGPT, que são treinados com base em grandes quantidades de dados e podem resumir, processar e gerar linguagem, podem aproximar-nos da inteligência para fins gerais.

“Se tivéssemos realmente uma IA para fins gerais, poderíamos ter cuidados de saúde muito melhores, uma educação muito melhor, novas e espantosas formas de entretenimento e literatura e novas formas de arte que ainda não existem", afirmou Russell.

Mas é impossível dizer se os modelos de linguagem de grande dimensão são seguros porque ninguém compreende verdadeiramente como funcionam: “Não sabemos se raciocinam; não sabemos se têm os seus próprios objetivos internos que aprenderam ou o que poderão ser”.

Russell apelou à reconstrução da IA numa base diferente para garantir o nosso controlo sobre a tecnologia - mas isso não resolve o problema potencial de os sistemas de IA caírem nas mãos de forças malignas.

... mesmo que saibamos como construir uma IA de uso geral perfeitamente segura, o que impede o Dr. Mal de construir uma IA de uso geral que vá destruir o mundo?” Stuart Russell

Russell também se preocupa com o facto de os humanos se tornarem demasiado dependentes da tecnologia e perderem "o incentivo para aprender e para serem capazes de qualquer coisa. E isso, penso eu, seria outra forma de catástrofe", afirmou.

Leia abaixo a nossa conversa, que foi editada e condensada para maior clareza.

CNN: Como alguém que está no terreno e estuda a IA há muitas décadas, qual é a sensação de, de repente, a IA ser um tema de interesse tão grande?

STUART RUSSELL: A IA existe como disciplina desde 1956. E sempre houve uma confusão entre a disciplina, que é o problema de tornar as máquinas inteligentes, e os artefactos que produz.

Atualmente, o que entusiasma muita gente são os grandes modelos linguísticos. São um produto da IA, mas não são IA. É como confundir a física com os telemóveis, certo? Os telemóveis são um produto da física - não são a mesma coisa que a física.

Como investigador nesta área, quando leio coisas, apetece-me dizer: "Não, não, estão a perceber tudo mal". Provavelmente a maior confusão que vemos é o facto de muita gente que escreve falar da grande questão como sendo: estas coisas são conscientes? Na verdade, ninguém neste domínio tem respostas para esse tipo de perguntas e elas são irrelevantes para a questão de saber se os sistemas de IA representam um risco para a humanidade.

Dentro do campo, o que pensamos é, por exemplo, se esta tecnologia em particular constitui parte de uma solução para o problema de longa data da criação de sistemas inteligentes de uso geral, o que significa, grosso modo, sistemas capazes de aprender rapidamente um comportamento de alto desempenho em qualquer tipo de ambiente de tarefas em que o intelecto humano seja relevante.

Pensamos que estes grandes modelos de linguagem são uma peça desse puzzle, mas ainda não descobrimos qual é a forma dessa peça...” Stuart Russell

Penso que a maioria das pessoas neste domínio acredita que os modelos linguísticos de grande dimensão são parte da solução. Uma metáfora que considero útil é pensar num puzzle. E, se conseguirmos encaixar tudo, teremos sistemas inteligentes de uso geral. Pensamos que estes grandes modelos linguísticos são uma peça desse puzzle, mas ainda não descobrimos qual é a forma dessa peça e, por isso, não sabemos como encaixá-la nas outras peças. E a razão pela qual ainda não descobrimos a forma da peça é porque não fazemos ideia do que se passa no seu interior.

Então, o que é que sabemos sobre o funcionamento destes grandes modelos linguísticos? Sabemos alguma coisa sobre o seu funcionamento?

Russell: Numa primeira aproximação? Não. Isso parece esquisito, mas posso dizer-vos como fazer um. Antes de mais, o que é um grande modelo linguístico visto de fora? É um sistema que recebe de entrada uma sequência de palavras e, basicamente, prevê qual vai ser a palavra seguinte e, se lhe for pedido, produz essa palavra seguinte.

Para fazer essa previsão, começa com… - pense nisto como uma cerca feita de uma corrente com elos. E que cada pequeno elo desse circuito pode ser afinado. À medida que se afinam as forças de ligação no circuito, a capacidade de saída do circuito altera-se. E digamos que esse circuito tem cerca de um bilião de elos - uma vedação de arame que cobre 1300 quilómetros quadrados. E depois treinamo-la com 20 ou 30 biliões de palavras e ajustamos todas essas ligações para que ele seja bom a prever a palavra seguinte. E depois é esperar pelo melhor.

Se treinarmos tudo isso, todos esses biliões de palavras de texto, obtemos um sistema que se comporta muito mal. Dar-nos-á conselhos sobre como fabricar armas químicas - não tem quaisquer restrições ao seu comportamento.

Depois há outra fase, que é uma coisa relativamente nova chamada aprendizagem por reforço a partir do retorno (feedback) humano. Mas isso é apenas um termo técnico para dizer: “Cão bom!” e “Cão mau!”. Sempre que ele diz algo que não é suposto dizer, dizemos "Cão mau!" e isso faz com que ocorram mais ajustes em todas as ligações dessa enorme rede. E esperamos que, da próxima vez, ele não faça o mesmo.

Como é que eles funcionam, não sabemos. Não sabemos se eles sabem coisas. Não sabemos se raciocinam; não sabemos se têm os seus próprios objetivos internos que aprenderam ou o que eles poderão ser.

Porque eles estão a ser treinados para imitar o comportamento de seres humanos, todo esse texto é comportamento linguístico humano e os humanos que geraram esse texto tinham objetivos. O lugar natural onde vamos parar é a uma entidade com objetivos semelhantes.

Adoro a metáfora do cão bom e do cão mau. É muito útil quando tentamos pensar no funcionamento destes sistemas complexos. Voltando um pouco atrás, pode explicar a alguém que não estuda IA o que é exatamente a IA?

Russell: A inteligência artificial é o problema de como tornar as máquinas inteligentes. O que é a inteligência? Durante a maior parte da história deste campo, o significado de inteligência tem sido o de esperar que as ações do sistema atinjam os objetivos do sistema. Por exemplo, se tivermos uma aplicação de navegação no telemóvel e dissermos: “Leva-me ao aeroporto”, esperamos que as direções que ela nos dá tendam a levar-nos ao aeroporto, certo?

Portanto, é esta noção de sistemas que têm objetivos e, depois, até que ponto atingem esses objetivos através das ações que escolhem? Esta é a noção central de inteligência que temos vindo a utilizar no terreno desde o início.

Pode falar-nos da história da IA e do seu desenvolvimento desde os anos 50, e da forma como a tecnologia tem avançado ao longo dos anos?

Russell: Desde a década de 1950, a IA, enquanto campo, produziu uma série de tecnologias diferentes que são úteis para a construção de sistemas inteligentes. Em termos gerais, a maior divisão é entre aquilo a que chamamos aprendizagem automática - que são sistemas que aprendem através da sua própria experiência para melhorar a realização dos seus objetivos - e outros tipos de abordagens que não envolvem aprendizagem.

Assim, por exemplo, a aplicação de navegação [automóvel por gps] não faz qualquer aprendizagem e não foi criada através da aprendizagem. Foi criada por cientistas informáticos que descobriram bons algoritmos para encontrar caminhos curtos para chegar a um objetivo num mapa.

Na década de 1950, o primeiro programa significativo de aprendizagem automática foi desenvolvido por um cavalheiro chamado Arthur Samuel. E esse sistema aprendeu a jogar damas sozinho - quando ganhava contra si próprio, ajustava vários parâmetros do programa para recompensar o que quer que fosse que tivesse feito. E se perdesse, alterava-os para evitar que isso voltasse a acontecer.

Na verdade, ele tornou-se muito melhor a jogar damas do que o Samuel. Não chegou ao nível de campeão mundial, mas tornou-se num programa de jogo de damas bastante impressionante. Foi mostrado na televisão em 1956 e causou um alvoroço comparável, diria eu, ao que se está a passar agora com o ChatGPT.

E na verdade, mais tarde, escreveu-se sobre a possibilidade de que, se esta tecnologia continuasse a seguir estas direções, ela representaria uma ameaça.

Assim, as tecnologias de aprendizagem, em particular, sempre pareceram ser particularmente ameaçadoras, assustadoras ou, pelo menos, imprevisíveis, porque, embora definamos a direção da aprendizagem, não podemos prever qual será o resultado.

Outra grande classe de tecnologias que começou a tornar-se popular entre o final dos anos 60 e meados dos anos 80 são os chamados sistemas baseados no conhecimento. Um tipo específico era designado por sistema especializado, em que o conhecimento era extraído de peritos. Assim, poderia tratar-se de conhecimentos sobre os componentes de um motor a jato e a forma como se encaixam, que tipo de coisas correm mal e assim por diante. E depois podia-se utilizar isso para reparar um motor a jato quando este se avaria.

Em meados da década de 1980, os sistemas especializados tornaram-se uma tecnologia muito promissora, com muitas empresas em fase de arranque e muito investimento. Mas verificou-se que a tecnologia não era suficientemente robusta para funcionar em muitas destas aplicações.

A partir do final da década de 1980, registaram-se dois desenvolvimentos importantes. Um foi uma nova tecnologia para raciocinar sob incerteza utilizando a teoria das probabilidades, que atribui aos resultados potenciais um número de 0 a 1 com base na sua probabilidade. Desde então, tem havido muitos desenvolvimentos e melhorias destas ideias.

A outra direção foi o renascimento das redes neuronais - um tipo particular de algoritmo de aprendizagem explorado pela primeira vez nas décadas de 1950 e 1960, que se inspirou na rede de neurónios do cérebro humano. Mas eram extremamente limitados no que podiam fazer. No final dos anos 80, desenvolvemos métodos que permitiam o treino de redes neuronais de maior dimensão (os grandes modelos linguísticos, como o ChatGPT, são um tipo de rede neuronal).

Mais uma vez, voltando à imagem de uma vedação como uma corrente de elos, em que cada elo é ajustável: quando se afinam todas as forças de ligação, isso altera o resultado da rede. E desenvolvemos algoritmos que nos permitiram ajustar as forças de ligação de todos os elos, mesmo que a vedação fosse muito grande. Foi um grande passo em frente, o que significa que agora podíamos treinar redes capazes de reconhecer objetos em imagens, reconhecer palavras a partir de um sinal de voz, etc.

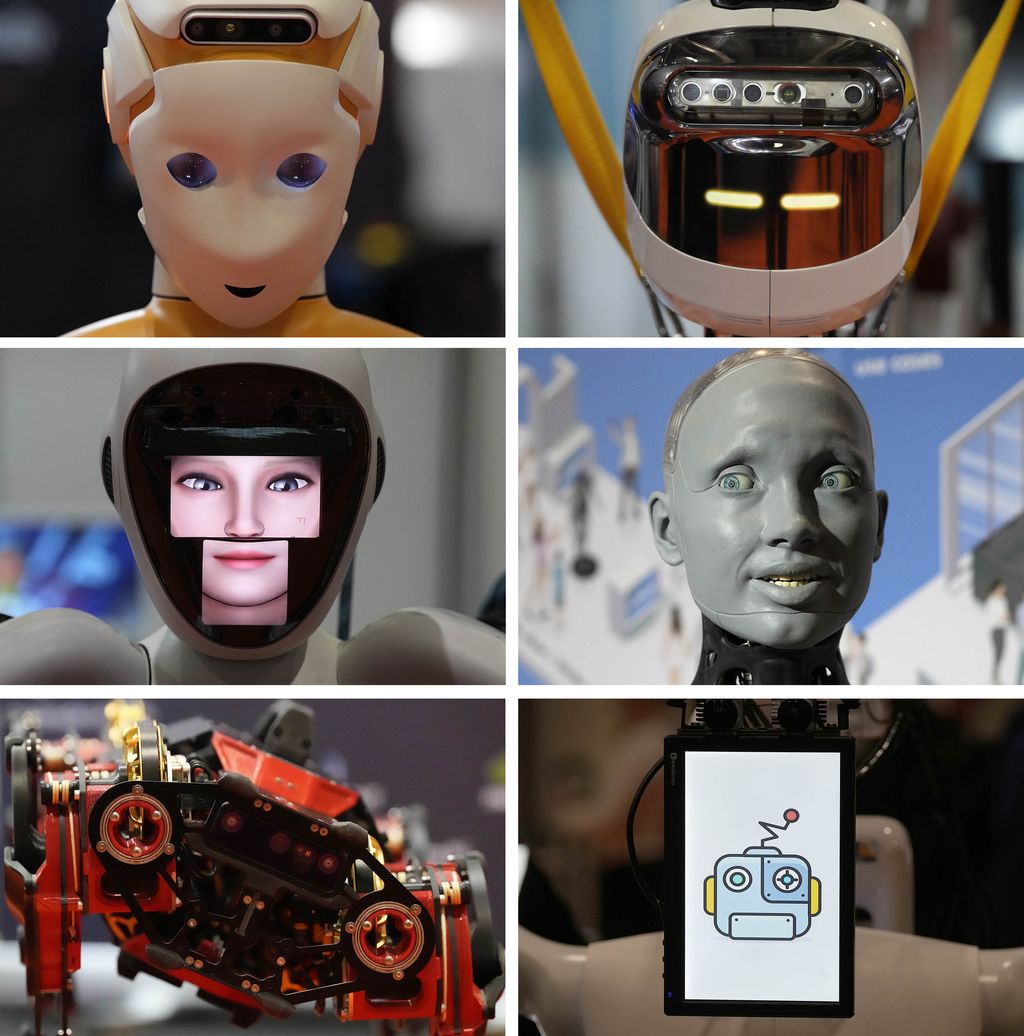

Há outras grandes áreas de trabalho em IA. Há a robótica, que consiste em saber como criar um robô físico que possa fazer algo de útil no mundo e, depois, como o programar. Há a visão por computador, que permite às máquinas percecionar o mundo visual através de algoritmos que analisam imagens e vídeos. Existem áreas de aplicação mais específicas, como o diagnóstico médico, os jogos, etc. A variedade é infinita, porque a mente humana é muito variada no que pode fazer.

Temos muitos grandes nomes da tecnologia a apregoar as promessas da IA, e depois temos os céticos que olham para alguns dos resultados do ChatGPT e dizem que não mostram necessariamente que a IA tem os seus próprios objetivos - talvez esteja apenas a dizer coisas aleatórias. Diria que estamos num ponto de viragem neste momento? Até que ponto é que isto é uma excitação exagerada? Quanto disto representa um verdadeiro ponto de viragem tecnológico?

Russell: Acho que é muito difícil dizer. Tenho sido cético em relação aos grandes modelos linguísticos como um caminho para a verdadeira inteligência.

Mas, dito isto, se lermos o artigo da Microsoft intitulado “Sparks of Artificial General Intelligence”, vemos que há dois membros das Academias Nacionais dos EUA na lista de autores e várias outras pessoas que deram muitos contributos para a IA.

Eles passaram várias semanas a trabalhar com o GPT-4, a versão mais recente do ChatGPT, a tentar perceber o que pode e não pode fazer. Os investigadores escreveram: “Demonstramos que, além do seu domínio da linguagem, o GPT-4 consegue resolver tarefas novas e difíceis que abrangem a matemática, a codificação, a visão, a medicina, o direito, a psicologia e muito mais, sem necessitar de qualquer estímulo especial”. Portanto, eles tiveram muito mais experiência com ele do que quase toda a gente. E o facto de eles dizerem que mostra sinais de inteligência artificial geral é um desenvolvimento bastante chocante.

Por isso, penso que é um ponto de viragem - definitivamente é um ponto de viragem na perceção do público, porque há muitos tipos de IA que estão muito em segundo plano. Quando se faz qualquer tipo de compra com cartão de crédito, muitas vezes há um sistema de IA a tentar descobrir se se trata de uma transação fraudulenta, por exemplo. Portanto, há muitos sítios como este em que a IA é um pouco invisível.

E depois houve coisas que se tornaram mais visíveis durante curtos períodos de tempo, como o Deep Blue a derrotar Garry Kasparov no xadrez em 1997, que foi um grande momento de manchetes de primeira página nos noticiários de noite. Mas o que tende a acontecer é que as pessoas dizem: “Ok, bem, isso é impressionante. Mas isto é apenas uma aplicação limitada e não significa que a verdadeira IA esteja ao virar da esquina”.

Estes acontecimentos vão e vêm como fogo-de-artifício.

Este ChatGPT - está à vista de todos. Não é uma IA para fins gerais, mas está a dar às pessoas uma amostra do que o será. A IA para fins gerais será completamente transformadora quando se concretizar.

Se num extremo do espectro temos a tecnologia mais rudimentar dos anos 50, em que se pode jogar damas bastante bem, e no outro extremo temos sistemas de IA que são tão inteligentes como os humanos, se não mais inteligentes, onde nos situaria neste momento?

Russell: Penso que essa é uma pergunta muito razoável, mas há dois problemas em responder-lhe. Um é que não fazemos a mais pequena ideia, certo?

Sim. E um dos extremos do espectro ainda é hipotético neste momento. Por isso, devo acrescentar isso como uma advertência.

Russell: Sim. Uma vez que não sabemos o que se passa dentro dos grandes modelos linguísticos, é muito difícil dizer. Será que temos mesmo peças do puzzle? Há uma expressão, “papagaio estocástico”, que alguns dos críticos têm usado. Estocástico significa que é ligeiramente aleatório e imprevisível, o que é correto. Porque se lhe perguntarmos a mesma coisa duas vezes, ele pode dar-nos um resultado ligeiramente diferente. E papagaio significa apenas que está a repetir coisas que leu sem compreender.

Diria que é mais do que um simples papagaio. Pense num pedaço de papel. Aqui está um pedaço de papel, e eu posso ler um parágrafo. Mas quem pensa que este pedaço de papel é inteligente - está apenas confuso, certo? O pedaço de papel parece inteligente porque o pedaço de papel está a transportar informação de alguém que é inteligente.

Então, onde estão os grandes modelos de linguagem entre um pedaço de papel e um ser humano? Não sabemos. Serão apenas pedaços de papel muito inteligentes devido a este processo de treino? E penso que também temos de ter em conta a tendência dos humanos para assumir que tudo o que consegue produzir texto coerente, gramatical e sofisticado é inteligente. Quando vemos este material a sair do ChatGPT, não podemos deixar de pensar que há inteligência por detrás dele.

Se retirarmos todo o efeito da prosa coerente, gramaticalmente correta, elegante e sofisticada, e olharmos para o que está por baixo, quanta inteligência resta? Não podemos fazer isso porque não nos podemos inocular contra este efeito de perceção da inteligência.

O computador tem milhares ou milhões de jogos de xadrez nos seus dados de treino. Mas, de vez em quando, talvez na altura em que chegamos à jogada 18, a nossa sequência de jogadas é suficientemente diferente de tudo o que está nos dados de treino para que ela faça uma jogada que não faz sentido nenhum. E nós chamamos-lhe alucinação.

Mas pode acontecer que estejam sempre a alucinar e que, na maior parte das vezes, estejam de acordo com os dados de treino, pelo que parecem plausíveis. Mas talvez, na realidade, não tenha qualquer modelo interno do mundo. E não está a responder a perguntas relativas à sua compreensão do mundo da mesma forma que nós.

Mas penso que há provas suficientes de que algo está a acontecer para me convencer de que é uma peça do puzzle da inteligência de propósito geral. Só não sabemos exatamente qual é a peça. Não sabemos como encaixá-la no puzzle.

Então, em termos de pensar na forma como a IA pode resolver alguns dos nossos maiores problemas, quais são as promessas?

Russell: Porque é que as coisas custam dinheiro? Em grande parte porque para as produzir é necessário o tempo de outros seres humanos. E se todo esse tempo for gratuito, porque agora é um sistema de IA ou a sua extensão robótica, então podemos proporcionar uma elevada qualidade de vida a toda a gente na Terra.

Penso que a maioria das pessoas diria que isso seria uma coisa boa.

Se tivéssemos de facto uma IA de uso geral, poderíamos ter muito melhores cuidados de saúde, muito melhor educação, novas formas espantosas de entretenimento e literatura e novas formas de arte que ainda não existem. Mesmo que se verifique que precisamos de biliões de dólares para construir as próximas gerações destes sistemas, penso que veremos esses investimentos de biliões de dólares acontecerem.

Há também muitas vantagens nos pontos intermédios no caminho para a inteligência de uso geral. Os carros autónomos - se funcionarem e se generalizarem, poderão salvar, penso eu, 1,35 milhões de vidas perdidas em acidentes de viação todos os anos. Por isso, se tudo correr bem, podemos salvar esses 1,35 milhões de vidas. Portanto, há muitos, muitos, muitos exemplos como este de potenciais benefícios.

Mas temos de tratar dos riscos.

Russell: Permitam-me que comece pelo presente e pelo risco dos sistemas que já existem no mundo. Penso que o maior risco ou as maiores desvantagens que já vimos vêm provavelmente dos algoritmos das redes sociais. Em termos genéricos, chamam-se sistemas de recomendação e o que fazem é escolher o que se lê e o que se vê.

Por isso, têm mais controlo sobre o consumo cognitivo humano do que qualquer império ou ditador da história e, no entanto, não estão completamente regulamentados, o que é uma situação estranha em que nos encontramos.

Estes algoritmos, penso eu, aprenderam a manipular as pessoas progressivamente ao longo do tempo, transformando-as em versões mais previsíveis de si próprias. Isso conduzirá a uma espécie de polarização - as pessoas começariam no meio e acabarão algures nos extremos. E depois temos pessoas a viver em universos diferentes uns dos outros por causa da desinformação - até há pouco tempo eram sobretudo os humanos que forneciam a desinformação e os algoritmos que a amplificavam. Com a IA, a desinformação pode ser gerada de forma automatizada e adaptada especificamente a cada pessoa.

Penso que há muitos exemplos de sistemas que aprendem a funcionar de forma discriminatória. Quer seja por raça ou por género, esses sistemas estão a ser utilizados em áreas importantes como a filtragem de currículos. Assim, uma pessoa pode candidatar-se a 100 empregos e não conseguir uma única entrevista, e há qualquer coisa no seu currículo que faz com que os sistemas o rejeitem.

Há também muitas utilizações incorretas. Já existe chantagem automatizada - sistemas que leem os seus e-mails, descobrem que está a fazer algo que não devia e começam a chantageá-lo com essa informação de forma personalizada e em massa. Trata-se de um problema real.

O impacto no emprego é outra coisa que preocupa muito as pessoas.

Penso que neste momento a tecnologia não é suficientemente fiável devido a coisas como a alucinação. Os presidentes executivos (CEO) perguntam-me: “Bem, onde posso utilizar isto na minha organização?” Eu respondo: “Onde quer que atualmente utilizem uma criança psicótica de 6 anos que vive num mundo de fantasia, substituam essa criança de 6 anos por um modelo de linguagem de grande dimensão”. Se sou uma companhia de seguros, se vou falar com os meus clientes, não posso prometer que vou segurar uma casa em Plutão. Então, como é que os tornamos fiáveis e verdadeiros? E é nisso que as pessoas estão a trabalhar.

Quando o fizermos, podemos começar a substituir muitos trabalhadores humanos.

Outra grande preocupação é a educação, certo? Como é que se pode motivar os alunos a aprender, a pensar e a escrever argumentos e ensaios, etc., quando o ChatGPT já o consegue fazer em dois segundos? É como se um tsunami tivesse acabado de chegar a praticamente todos os sectores da nossa sociedade.

Se criarmos sistemas mais poderosos do que os seres humanos, como é que os seres humanos mantêm o poder sobre esses sistemas para sempre?" Stuart Russell

Depois, há este fenómeno geral a que chamamos desalinhamento, ou seja, os objetivos que os sistemas perseguem não estão alinhados com os interesses dos seres humanos. Por isso, à medida que criamos sistemas cada vez mais capazes, se estiverem desalinhados, estamos basicamente a criar um jogo de xadrez entre a humanidade e uma máquina que persegue esse objetivo desalinhado. Esta é, portanto, a grande questão em que muitos investigadores, incluindo eu próprio, se têm concentrado. Há cerca de uma década que ando a pensar nisto: se criarmos sistemas mais poderosos do que os seres humanos, como é que os seres humanos mantêm o poder sobre esses sistemas para sempre?

Sei que defende a construção de sistemas de IA de modo a que respondam aos nossos objetivos em vez de perseguirem os seus próprios objetivos. Estou curioso, tendo em conta os desenvolvimentos dos últimos anos, acha que isso ainda é possível?

Russell: Sim, é uma boa pergunta. Penso que o trabalho que tem sido feito neste sentido tem avançado muito lentamente.

O que é que nós, a raça humana, queremos que seja o futuro? É muito difícil perceber isso. E, claro, somos 8 mil milhões e todos queremos coisas um pouco diferentes. Por isso, talvez a abordagem correta não seja estabelecer objetivos fixos, mas dizer que o sistema de IA deve ajudar-nos com o futuro que queremos, mas começa por não saber qual é esse futuro.

E assim, verifica-se que é possível construir sistemas de IA que têm essas propriedades, mas são muito diferentes dos tipos de sistemas de IA que sabemos construir. Toda a tecnologia que construímos até agora baseia-se nesta ideia de colocar um objetivo fixo e depois a máquina descobre como atingir o objetivo.

Por isso, temos de desenvolver a IA de novo sobre esta base diferente. E temos um longo caminho a percorrer para voltar a desenvolver toda a teoria, todos os algoritmos, e depois começar a produzir sistemas práticos que terão de competir no mercado.

Penso que há estimativas que dizem que há menos de 100 pessoas no mundo a trabalhar neste domínio. Entretanto, há dezenas de milhares de milhões de dólares a serem investidos na abordagem antiquada da IA - aquela que não funciona bem a longo prazo, que produz consequências desalinhadas e, eventualmente, talvez catastróficas.

Por isso, penso que é difícil, mas os governos de todo o mundo estão a despertar para esta questão. Quando houver legislação, penso que terá de haver um compromisso muito sério com o que significa tornar estes sistemas seguros. E, tanto quanto me é dado ver, dado que não sabemos como funcionam, não há forma de mostrar que os grandes modelos linguísticos e os seus descendentes são seguros.

Por isso, acha que as empresas deviam ser obrigadas a ser transparentes em relação a esses ajustes dentro da caixa negra?

Russell: Bem, não importa que sejam transparentes porque não compreendem como funciona. Não é que nós não percebamos. Eles é que não percebem. Por isso, poderiam certamente dizer: “Aqui estão os biliões de parâmetros da nossa rede”. E, de facto, há vários sistemas que já são públicos. Mas isso não ajuda se não conseguirmos compreender os seus princípios internos de funcionamento.

Voltando à regulamentação, vemos os governos, pelo menos nos EUA, a esforçarem-se por regulamentar as redes sociais. E depois temos estas empresas que têm um interesse financeiro óbvio em fazer avançar os desenvolvimentos da IA. É realista esperar que exista algum tipo de organismo internacional de controlo ou de regulamentação?

Russell: Quando mencionei o fracasso da regulamentação, o fracasso é simplesmente não fazer nada a esse respeito. Não basta subscrever um conjunto de princípios - estes não têm força enquanto não forem transformados em regulamentação.

Por isso, penso que o que provavelmente vai acontecer é que todos os grandes países vão precisar de agências reguladoras, tal como a Federal Aviation Administration [equivalente norte-americana à portuguesa ANAC] para a aviação, ou a Nuclear Regulatory Commission para a energia nuclear. Essas agências têm poderes descentralizados, pelo que o Congresso não está a debater os pormenores dos grandes modelos linguísticos e o tipo exato de critérios de segurança a aplicar.

Penso que a maioria dos países vai criar agências como estas para a IA, e depois terá de haver algum tipo de mecanismo de coordenação para todas essas agências. Porque a última coisa que se quer é que todos os criadores se desloquem para o país que tiver a regulamentação mais laxista, certo? Temos este problema com os impostos e as pessoas vão para o Luxemburgo, para as Ilhas Caimão e por aí fora.

Eu diria que, atualmente, os Estados Unidos são o país mais laxista em termos de regulamentação. A Califórnia tem uma lei que diz que os sistemas de IA não podem fazer-se passar por humanos com o objetivo de os convencer a votar num determinado candidato numa eleição. Óptimo. Óptimo. Há muito mais que precisa de ser feito e não se pode fazer isto de forma fragmentada, estado a estado.

Por isso, penso que é isto que vai acontecer, mas tudo isto leva tempo. Não participei na redação da carta aberta que apelava a uma pausa imediata no treino de sistemas de IA mais potentes do que o GPT-4, mas penso que era essa a preocupação subjacente - que precisamos que as coisas avancem mais rapidamente, para garantir que o ambiente regulamentar está em vigor antes que surja uma IA incontrolável de uso geral.

Então, isso não é inevitável - se tivermos os regulamentos corretos, podemos impedir que a IA se torne mais inteligente do que os humanos?

Russell: Bem, o objetivo não é impedir que a IA se torne mais inteligente do que os humanos. O objetivo é que, à medida que se torna mais poderosa, imponhamos certas restrições de conceção que resultem em controlo e segurança. Os aviões são mais rápidos do que as pessoas, mas têm de ser seguros para que se possa transportar passageiros neles. E podemos fazê-los tão rápidos quanto quisermos.

Penso que há outras razões para nos preocuparmos com a criação de sistemas mais inteligentes do que os seres humanos, sobretudo relacionadas com o nosso próprio autoconceito. Mesmo que sejam seguros e benéficos, etc., o que é que isso faz à nossa conceção de nós próprios, à nossa motivação e à estrutura da nossa sociedade quando tudo aquilo de que beneficiamos está a ser produzido pelas máquinas e já não por nós?

Não sei se viram o filme “Wall-E” - porque destruímos o nosso próprio planeta, a humanidade é deixada nestas naves espaciais gigantes comandadas por robots. E como os robots tomaram conta da gestão da civilização, não há incentivo para os humanos aprenderem a gerir a nossa civilização.

E assim vê-se os humanos a ficarem infantilizados e enfraquecidos. O filme está a mostrar uma tendência na nossa civilização, penso eu, que se aceleraria enormemente se tivéssemos IA de uso geral, que é tornarmo-nos dependentes da tecnologia e depois perdermos o incentivo para aprender e para sermos capazes de qualquer coisa. E isso, penso eu, seria outra forma de catástrofe.

Qual é a sua esperança para o futuro?

Russell: Espero que haja regulamentação suficiente para que os criadores destes sistemas levem a sério a sua responsabilidade de compreender o seu funcionamento e garantir que funcionam de forma segura e previsível. E que o desenvolvimento desses sistemas seja acompanhado de uma maior compreensão e de uma regulamentação muito mais rigorosa. A longo prazo, o próximo problema que vamos enfrentar é que, apesar de podermos compreender como construir uma IA de uso geral perfeitamente segura, o que impede o Dr. Mal de construir uma IA de uso geral que vai destruir o mundo?

À partida, poderíamos pensar: “Muito bem, vamos ter leis muito rigorosas sobre isso”, mas temos leis muito rigorosas sobre “malware” e cibercrime e, no entanto, o “malware” e o cibercrime quase não estão extintos. Por isso, a única forma de o fazer é mudar toda a nossa infraestrutura digital. O que a infraestrutura digital faz atualmente é executar qualquer coisa, a menos que reconheça que é perigoso. Se tivermos um software antivírus no nosso computador portátil e for descarregado um vírus conhecido, o sistema deteta-o e elimina-o. Mas o que precisamos, na verdade, é que os sistemas funcionem ao contrário - precisamos de garantir que o hardware e o sistema operativo não executem nada a menos que saibam que é seguro.

Trata-se de uma grande mudança em todo o ecossistema digital global, mas penso que é a única solução.